Plenoptische Kameras, die sogenannten Lichtfeldkameras, nehmen Lichtfelder am besten auf. Wie verwenden robotische Systeme Lichtfelddaten? Welche neuen Eigenschaften entstehen durch diese Kameras? Wie werden sie richtig kalibriert? In diesem Beitrag beleuchten wir mithilfe der Kamera-Einführung des DLR das Konzept näher.

Lichtfeld

Ein Lichtfeld ist eine 4D-Datensatz, der ein hohes Potential bietet, um die Perzeption zukünftiger Roboter zu verbessern. Seine hohe Präzision und Detailgenauigkeit können der automatisierten Objekterkennung entscheidende Vorteile bieten. Die 4D-Daten entstehen dabei folgendermaßen: Es existiert eine 2D-Pixelmatrix des Sensors, welcher im 3D-Raum verrückt werden kann und das Lichtfeld aufnimmt. Dies wäre allerdings 5D. Da es in der Berechnung keinen Unterschied macht, wenn die Kamera in Richtung des Lichtstrahls verschoben wird, lässt sich eine Dimension aus dieser Gleichung streichen – ein 4D-Datensatz entsteht.

Im Vergleich zu herkömmlichen 2D-Bildern besitzt eine 4D-Lichtfeld also zwei zusätzliche Dimensionen, die aus der räumlichen Verschiebung resultieren und die Tiefe der vorgefundenen Szene widerspiegeln. Durch diese ist es möglich, zusätzliche Informationen zu erhalten und verschiedene Datenprodukte zu erschließen. Am häufigsten nutzt die industrielle Anwendung des Lichtfelds auf einen bestimmten Abstand fokussierte 2D-Bilder oder 3D-Tiefenbilder (Punktwolken) ab.

Eigenschaften des Lichtfelds mithilfe der plenoptischen Funktion

Herkömmliche Kameras stellen die Sicht des menschlichen Auges nach. Hierbei betrachtet die Kamera eine Szene von einer fixen Position aus und fokussiert ein bestimmtes Objekt. Diese Kameras bündeln eine Auswahl von Lichtstrahlen einer Szene, um ein Einzelbild zu formen.

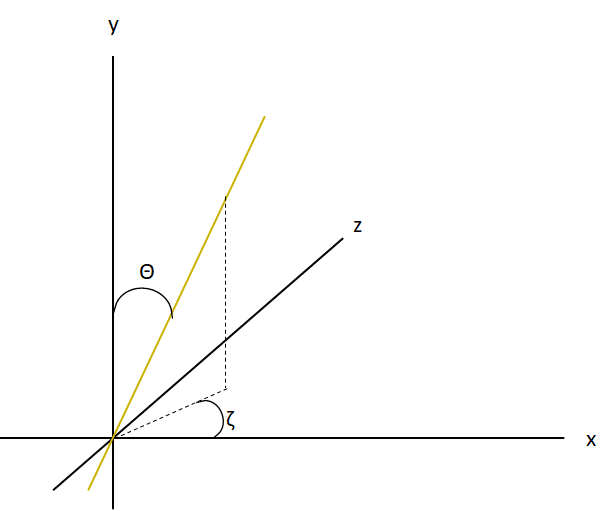

Im Gegensatz dazu enthält ein Lichtfeld nicht nur die Lichtintensität an der Position, an der ein Lichtstahl auf den Kamerasensor trifft, sondern auch die Richtung, aus der der Lichtstahl eintrifft. Die Intensität, also die vom Sensor gemessene Lichtmenge, an Position (u, v) und die Richtungswinkel (Θ, ζ) sind Informationen, die ein 4D-Lichtfeld mittels Rendering erstellt. Sie sind Bestandteile der sog. plenoptischen Funktion, mit der das Lichtfeld physikalisch beschrieben werden kann.

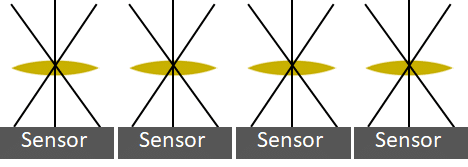

Dank der zusätzlichen zwei Dimensionen sind weitere Datenprodukte möglich: Am häufigsten treten 2D-Bilder auf. Diese werden zum Beispiel auf einen bestimmten Abstand fokussiert oder weisen einen erweiterten Tiefenschärfebereich auf. Eine zusätzliche Möglichkeit ist das Erstellen eines 3D-Tiefenbildes. Mit einer einzigen Aufnahme ist es nun machbar, mehrere direkt miteinander verwandte Datenprodukte zu erzeugen.

Um das Lichtfeld in Anwendung zu bringen und seine Informationen produktiv zu nutzen, benötigt es eine dazugehörige Software bzw. einen Algorithmus, der diese Daten auswertet. Lichtfeld-Aufnahmen sind aufgrund ihrer vier Dimensionen sehr groß und bedeuten daher einen hohen Rechenaufwand. Aus diesem Grund steht die industrielle Nutzung plenoptischer Kameras noch am Anfang – erst seit kurzer Zeit ermöglichen leistungsstarke Computer die Verarbeitung dieser Daten in ausreichend kurzen Zeitspannen. Von der Aufnahme zur 3D-Punktwolke ist dies aktuell in ca. 50 ms möglich.

Doch wie genau muss eine Kamera beschaffen sein, die das Lichtfeld solchermaßen erfassen kann?

Plenoptische Kameras

Plenoptische Kameras entstehen durch die Modifizierung herkömmlicher Kameras. Durch die theoretische unendliche Schärfentiefe und der Möglichkeit der Refokussierung ist es möglich, die Schärfeebene nachträglich im Objektraum zu verschieben. Durch diese zusätzliche Tiefeninformation kann eine Plenoptische Kamera auch als 3D-Kamera verwendet werden.

Um die plenoptische Funktion abzubilden, gibt es grundsätzlich zwei physikalische Möglichkeiten:

- Lichtfeld-Erfassung mit Mikrolinsen

- Lichtfeld-Erfassung mit Kamera-Arrays

Lichtfeld-Erfassung mit Mikrolinsen

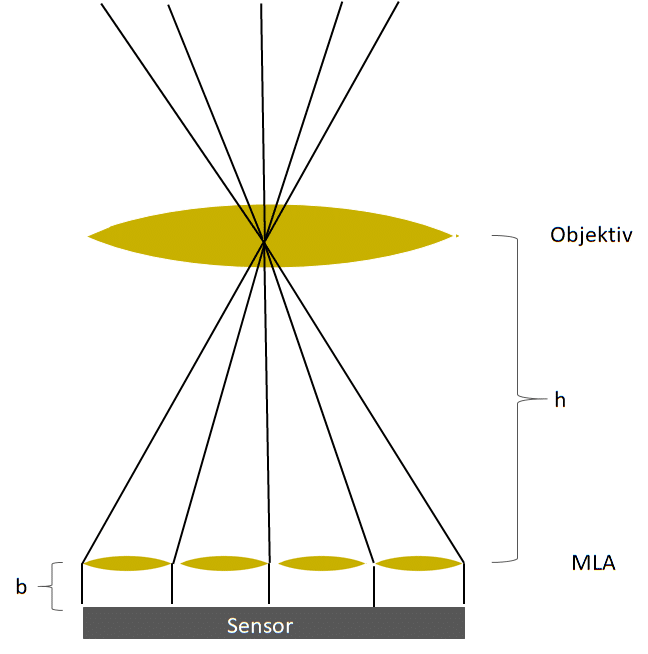

Bei einem Mikrolinsen-Array (Micro Lense Array (MLA)) sitzt eine Platte mit Mikrolinsen vor dem Kamerasensor. Eine Mikrolinse ist eine miniaturisierte Steuerungs- und Bündelungslinse. Sie bündelt das Licht optimal, um zu verhindern, dass Lichtstrahlen im Randbereich des Bildsensors auftreffen. So verhindert sie, dass Verzerrungen oder Helligkeitsdifferenzen auftreten. Je nach Licht-Typ muss die Mikrolinse aus einem anderen Material bestehen:

- Wellenlänge zwischen 150 nm und 4 μm: Siliziumdioxid

- Wellenlänge zwischen 1,2 μm und 15 μm (Infrarotlicht): Silizium

Das MLA ist eine Matrix aus einzelnen Mikrolinsen, welche die Szene aus verschiedenen Blickwinkeln erfassen. Jede dieser Linsen hat einen Durchmesser zwischen einigen Mikrometern und wenigen Millimetern. Der Sichtbereich umfasst dabei einige hundert Pixel. Die einfallenden Lichtstrahlen brechen sich in den Mikrolinsen, den physikalischen Gesetzen entsprechend. So fällt der Lichtstahl je nach Einfallsrichtung auf einem bestimmten Sensorpixel unterhalb der Mikrolinse. Die Position (u, v) entspricht also einer Mikrolinse und die Richtungswinkel (Θ, ζ) entsprechen einem Sensorpixel unterhalb dieser Linse.

Aufgrund ihrer geringen Größe im Sub-Millimeter-Bereich finden Lichtfeld-Microlinsen-Arrays insbesondere in den Life Sciences Anwendung – z.B. verbaut in Mikroskopen.

Lichtfelderfassung mit Kamera-Arrays

Ein Kamera-Array ist prinzipiell ein makroskopisch erweiterter Ansatz der Mikrolinsen. Statt einzelner Linsen kommen hier mehrere verbundene Kameras mit jeweils eigenen Linsen und Sensoren zum Einsatz. Die einzelnen Kameras werden dabei beispielsweise über einen Ethernet-Switch angesteuert. Das Abrufen der entstandenen Daten funktioniert dabei über eine Ethernet-Schnittstelle, um hohe Verarbeitungsgeschwindigkeiten zu erzielen.

Damit die so anfallenden Bilddaten der verschiedenen Kameras in ein Datenprodukt umgewandelt werden können, sind die Kameras in einem bekannten regelmäßigen Muster angeordnet. Nur so kann der dahinterstehende Algorithmus die Verschiebungen korrekt berechnen.

Durch die multiplen Kameras wird eine Szene aus unterschiedlichen Positionen beobachtet. Jede Kamera weist unterschiedliche Parameter auf:

- Brennweite der Abbildungsoptik

- Einstellung des Fokus

- Belichtungszeit

- Blende

- Aufnahmezeitpunkt

- Einsatz von Spektral- und Polarisationsfiltern

Mithilfe eines Kamera-Arrays ist die vollständige Inspektion einer Szene (z.B. 3D-Vermessung), die Ermittlung von Spektraleigenschaften (z.B. Farbe und Farbfehler) oder die Erfassung dielektrischer Eigenschaften (z.B. Polarisation) möglich.

Kamera-Arrays kommen aufgrund ihrer Größe nicht für den mikroskopischen Bereich infrage. Stattdessen spielen sie ihre Vorteile in größeren Anwendungen aus: in der industriellen Produktion kommen spezielle Kamera-Arrays für die Erkennung im Bereich weniger Zentimeter (z.B. Schrauben) bis Meter (z.B. für Paletten) zum Einsatz.

Verteilte Kamera-Arrays

Verteilte Kamera-Arrays bestehen aus mehreren Kameras, welche immer noch als einzelne Kameras modelliert sind. Das bedeutet, dass sich das gesamte Kamera-Array nicht mit gemeinsamen extrinsischen Parametern (= Lage der Kamera im Weltkoordinatensystem) beschreiben lässt. Zudem überlappen sich die räumlichen Erfassungsbereiche häufig nicht. Einsatzbereiche dieser Kamera-Arrays sind Überwachungssysteme für unterschiedliche Räumlichkeiten oder die industrielle Inspektion, bei der nur verschiedene Objektbereiche erfasst werden müssen.

Solche Systeme können sowohl homogene (z.B. Überwachungssysteme) als auch heterogene (z.B. Inspektionssystem) Sensoren beinhalten. Hierbei ergänzen sich die aufgenommenen Daten und sind somit komplementär. Um Überlappungen zu vermeiden, sollte die Anzahl der Kameras immer minimal bezüglich der Aufgabe gewählt werden.

Kompakte Kamera-Arrays

Die Kameras eines kompakten Kamera-Arrays sind gemeinsam modelliert und besitzen daher zusätzliche extrinsische Parameter, durch die es möglich ist, die Position des gesamten Kamera-Arrays bezüglich der Szene zu beschreiben. Die räumlichen Erfassungsbereiche überlappen sich hier in der Regel stark.

Ein solches System beinhaltet in der Regel homogene Sensoren. Die erfassten Informationen könne dabei sowohl komplementär, als auch verteilt (nur eine gemeinsame Auswertung der Bilder liefert die gewünschten Informationen) sein. Kompakte Kamera-Arrays sind zudem in der Lage, uni- (Variation eines einzigen Aufnahmeparameters) und multivariate (Variation mehrerer Aufnahmeparameter) Bilderserien zu erfassen.

Kompakte Kamera-Arrays gewinnen immer mehr an Bedeutung für viele unterschiedliche Anwendungen, da sie umfassende Möglichkeiten bieten, die visuell erfassbaren Informationen einer Szene vollständig zu erfassen.

Kalibrierung Plenoptischer Kameras

In der praktischen Anwendung kommt es häufig nicht nur auf die optische Erkennung an, sondern auch um die präzise Vermessung der aufgefundenen Werkstücke. Korrekt kalibriert, sind Plenoptische Kameras auch als Messsystem nutzbar: Die dazu notwendigen metrischen Informationen stammen direkt aus den Lichtfelddaten der Kalibrierung und den generellen Eigenschaften der plenoptischen Funktion.

Kommerziell erhältliche Plenoptische Kameras liefern Abstandswerte jedoch meist in nicht-metrischen Einheiten. Dies stellt eine Hürde für die Anwendung in der Robotik dar, da hier metrische Abstandwerte vorliegen müssen. Durch die Trennung der Konfiguration der traditionellen von den neuen Eigenschaften Plenoptischer Kameras ist es nun möglich, traditionelle Methoden der Kamerakalibrierung zu nutzen, um den Ablauf der Ausrichtung Plenoptischer Kameras zu vereinfachen und um die Genauigkeit zu erhöhen. Aktuell können so Genauigkeiten im Sub-Millimeter-Bereich erzielt werden. Hierbei kommt wie bei einer herkömmlichen Kamera das Modell einer Lochkamera zum Einsatz.

Das System verwendet zwei unterschiedliche Eingangsdatentypen, um diese beiden Schritte der Justierung durchzuführen. Diese Datentypen sind zum einen 2D-Bilder mit einem erweiterten Tiefenschärfebereich und zum anderen 3D-Tiefenbilder.

Der Rauschanteil der Tiefenschätzung beeinflusst so nicht mehr die Schätzung der traditionellen Parameter, wie die Brennweite oder die radiale Linsenverzerrung. Dadurch ergeben sich weitere Vorteile:

- Anwendung unterschiedliche Optimierungen auf die oben genannten Eingangsdaten. Dadurch ist es möglich, Ausreißer für den jeweiligen Datentyp gezielter zu reduzieren.

- Die Zweiteilung ist einfacher, wodurch neuartige und schnellere Initialisierungsmodelle für alle Parameter realistisch werden.

- Eine Vermischung der Modelle für Linsen- und Tiefenverzeichnung sowie die der inneren Größen (Brennweite f, Abstand b zwischen MLA und Sensor, Abstand h zwischen MLA und Objektivlinse) wird verhindert.

Plenoptische Kameras sind also in der Lage, die Tiefenschärfe auch im Nachhinein zu verschieben oder aus ihren Bildern unterschiedliche Datenprodukte zu erzeugen. Um die Daten richtig auswerten zu können, muss die Kalibrierung in zwei Schritte unterteilt werden. Dadurch verringert sich zunächst der Rauschanteil, wodurch die Tiefenschätzung möglich wird. Plenoptische Aufnahmetechniken sind demnach disruptive Technologien, die es ermöglichen neue Anwendungsbereiche zu erschließen und die traditionelle Aufnahmetechnik weiterzuentwickeln.

(Quelle: DLR, Beitrag überarbeitet am 04.11.2021)